Hiệu trưởng Google “thăm nom” và “chôm chỉa” thông tin website như thế nào?

October 14, 2020Dữ liệu được xem là một phần không thể thiếu của mỗi trang web bất kỳ khi thiết lập. Tuy nhiên, để giải quyết vấn đề người dùng thì ít mà kho dữ liệu thì nhiều khá khó khăn.

Nếu bạn đang tự hỏi làm thế quái nào Google có thể hiểu nội dung trên website bạn? Thì đã đến lúc bạn tìm hiểu Crawl và Index là gì?

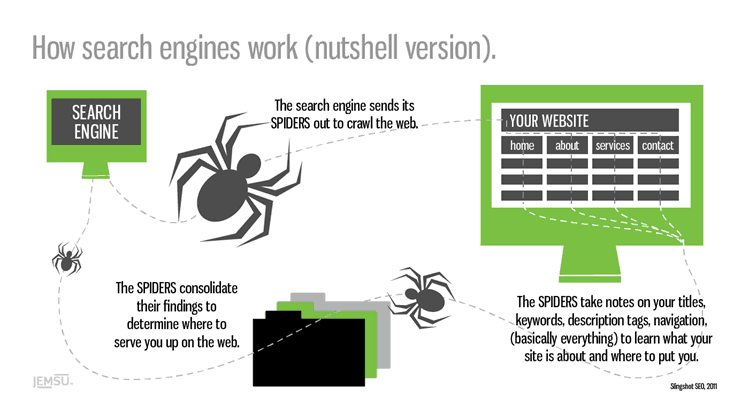

Google đã giải thích cách công cụ tìm kiếm hoạt động rằng “Before you search, web crawlers gather information from across hundreds of billions of webpages and organize it in the Search index.” (Trước khi bạn tìm kiếm, các cọn bọ đã thu thập thông tin từ hàng trăm tỉ các trang và sắp xếp nó trên kết quả tìm kiếm)

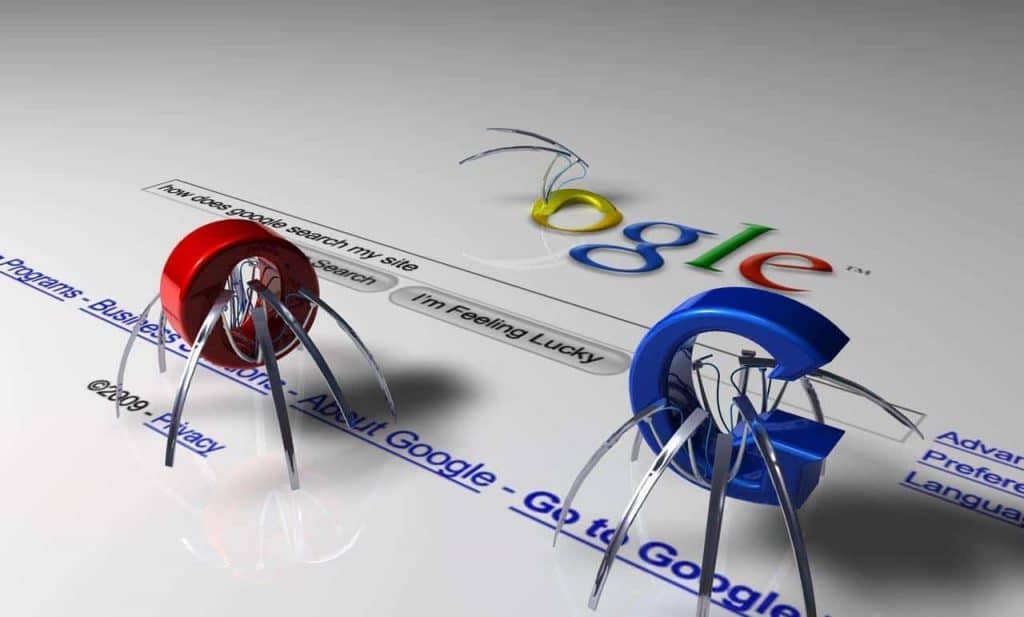

Web crawler hay còn được gọi là các spider hoặc spiderbot, thường được gọi tắt là crawler.

Chúng là những con internet bot (các con robot siệu nhỏ được lập trình sẵn), lướt qua hệ thống World Wide Web.

Crawl là gì?

Crawl là quá trình khi Google ghé thăm một website.

Để thực hiện mục đích thu thập thông tin được cho phép. Quá trình này được thực hiện bởi các con bọ (Spider crawler) của Google.

Bạn có thể tưởng tượng rằng Google đang tung ra hàng triệu triệu con robot nhỏ, luồn lách khắp trên thế giới internet để thu thập mọi thông tin có thể.

Nhưng bạn có thể sử dụng file robost.txt để chặn Google. Và chỉ cho chúng thu thập những gì bạn muốn.

Google Crawl là gì?

Crawl căn bản có thể hiểu là đi theo một con lối mòn.

Trong thế giới của SEO (Search Engine Optimization), crawl có nghĩa là các con bọ nó sẽ đi theo các links và thu thập thông tin.

Khi các bot đến website của bạn (hoặc bất kỳ trang nào), chúng cũng lần theo tất cả các trang được liên kết trên website đó. Đây chính là lí do vì sao mọi website cần có sitemap.

Vì chúng có chứa tất cả các đường link trên blog hay website. Các con bot của Google có thể sử dụng chúng để nhìn sâu hơn vào một website. Cách mà chúng ta có thể hạn chế hoặc chắn Google crawl website đó là sử dụng file robots.txt.

Index là gì?

Sau khi việc crawl đã hoàn thành, các kết quả sẽ được sắp xếp và hiện trên công cụ tìm kiếm Google. Bạn có thể hiểu như sau khi các con bọ của Google đi thập được thông tin của tất cả website trên thế giới. Sau đó dựa trên thuật toán của riêng Google sẽ sắp xếp và hiển thị các kết quả ở ví trị ở trang 1,2,3… trên Google Search.

Google index là gì?

Sau khi được Index, tất cả kết quả sẽ được hiển thị trên Google Search.

Google sẽ dựa vào các tín hiệu như: keyword, backlink và các thuật toán (Google RankBrain yếu tố quan trọng thứ 3). Hiện nay GG đã cho ra bắt rất nhiều thuật toán. Nhằm nâng cao chính xác kết quả tìm kiếm hơn, cũng như loại bỏ kết quả không tốt.Goolge Search Index chứa hàng trăm tỷ website ( kích thước > 100.000.000 gigabye). Nó giống như phần mục lục của một cuốn sách. Mỗi mục lục sẽ đại diện cho trang với từ khóa tương ứng.

Hy vọng bài viết này sẽ giúp ích cho bạn hiểu rõ hơn về Google Crawl và Index và các vấn đề xung quanh nó. Dù bạn đang là chuyên gia SEO thì mục đích cao nhất của mọi công cụ là phục vụ tốt cho người dùng. Do đó muốn bền vững lâu dài cần phải có nội dung chất lượng, hướng đến người dùng.

[…] ← Previous Next → […]

[…] Mình cũng đã đề cập tới cách mà google thu thập thông tin như thế nào?Bạn đọc có thể đọc lại tại:# http://blog.ntechdevelopers.com/google-dang-thu-thap-thong-tin-website-nhu-the-nao/ […]